Linux-Server sind überall, und entsprechend wichtig sind effiziente Backups in diesem Segment. Linux-Betriebssysteme laufen in den meisten Hypervisoren in der Private- und Public-Cloud. Linux läuft in physischen Clustern in der Private-Cloud und in virtuellen Maschinen in der Private-, Public- und Hybrid-Cloud. Nach Schätzungen von Gartner für das Jahr 2015, ist der Linux-Umsatz auf zwei Milliarden Dollar angewachsen und ist damit höher als der Unix-Umsatz, der bei 1,8 Milliarden Dollar lag. Auf drei Windows-Server kommen zwei Linux-Server. Damit in diesem Bereich Backups schneller und einfacher realisiert werden können, rät Actifio zur Virtualisierung von Datenkopien.

Linux-Server sind überall, und entsprechend wichtig sind effiziente Backups in diesem Segment. Linux-Betriebssysteme laufen in den meisten Hypervisoren in der Private- und Public-Cloud. Linux läuft in physischen Clustern in der Private-Cloud und in virtuellen Maschinen in der Private-, Public- und Hybrid-Cloud. Nach Schätzungen von Gartner für das Jahr 2015, ist der Linux-Umsatz auf zwei Milliarden Dollar angewachsen und ist damit höher als der Unix-Umsatz, der bei 1,8 Milliarden Dollar lag. Auf drei Windows-Server kommen zwei Linux-Server. Damit in diesem Bereich Backups schneller und einfacher realisiert werden können, rät Actifio zur Virtualisierung von Datenkopien.

„Unternehmen betreiben Hunderte von geschäftskritischen Anwendungen mit Datenbanken wie Oracle, DB2, MySQL, PostgreSQL und NoSQL unter Linux. Es ist nicht ungewöhnlich, Multi-TByte-Datenbanken und Dateisysteme in Linux-Systemen zu finden. Unternehmen wollen sicherstellen, dass diese Anwendungen nicht nur leistungsstark und sicher, sondern auch widerstandsfähig sind“, so Thorsten Eckert, Sales Director DACH bei Actifio. „Mit anderen Worten, ihre Daten werden gesichert und beibehalten, um ihre Compliance-Anforderungen zu erfüllen, und im Falle einer Katastrophe können diese Anwendungen sehr schnell mit minimalen Ausfallzeiten wiederhergestellt werden.“

Actifio sieht hierin die drei wichtigsten Überlegungen für professionelle Resilienz:

- Incremental-forever-Backup – Vollständige Backups wirken sich auf die Performance der Produktionsanwendung aus. Daher ist es wichtig, dass die Backup-Lösung in der Lage ist, Incremental-forever-Backups auszuführen, um die Auswirkungen auf die Produktionsanwendungen zu minimieren und Backup-Fenster um das bis zum zehnfachen zu reduzieren

- Instant-Recovery, also sofortige Wiederherstellung – Egal ob die Anwendung unter Linux-OS auf eine Multi-TByte-Datenbank oder ein großes Dateisystem mit Millionen von Dateien zugreift, sollte die Backup-Lösung in der Lage sein, Instant-Recovery innerhalb von wenigen Minuten durchzuführen. Eine niedrige RTO (Recovery-Time-Objective) und RPO (Recovery-Point-Objective) sind ein Muss für geschäftskritische Anwendungen.

- Infinite-Retention, also unbegrenzte Aufbewahrung – Unternehmen sollten die Flexibilität behalten ihre Backups für Stunden, Tage, Wochen, Monate, Jahre oder sogar Jahrzehnte, wenn sie müssen. Dennoch sollten sie immer noch die Möglichkeit haben, sofortigen Zugriff auf Daten zu gewähren, sei es Tage oder Jahrzehnte alt.

Eine Plattform zur Virtualisierung von Datenkopien kann diese Anforderungen erfüllen. Das folgende Beispiel zeigt wie ein Unternehmen, das große DB2-Datenbanken unter Linux OS betreibt, von solch einem Ansatz profitieren.

Problemsituation: Wiederholte VM-Stun-Probleme bei einer 2 TByte großen DB2-Datenbank. Deshalb Einsatz von Agenten-basiertem Backup. Dieser Ansatz erforderte jedoch wöchentliche vollständige Backups, was sich auf die Performance der Produktionsdatenbank auswirkte und das Backup-Fenster vergrößerte. Die RTO verlängerte sich ebenfalls wegen der Wiederherstellung vollständiger, inkrementeller und transaktionsbezogener Logs.

Lösungsansatz: Einsatz für Incremental-forever-Backups der DB2-Datenbank. Nutzung von Pre- und Post-Scripts für Datenbank-Konsistenz-Backups mit jeder inkrementellen Sicherung. 1 Stunde RPO mit stündlichem inkrementellem Backup. Niedrige RTO mit sofortiger Wiederherstellung zu jedem der einstündigen Point-in-Time-Images.

SLA-basierte Ansatz für einfaches Handling

Für jede Linux-VM oder physischen Linux-Server wird ein Connector installiert (ähnlich wie einen Agenten). Der Connector besitzt die Intelligenz, um zu verfolgen, welche Blöcke sich in einem Volume ändern. Der Administrator legt SLAs fest, die definieren, wann die virtuelle Appliance einer Plattform zur Datenvirtualisierung eine Sicherung initiieren muss – beispielsweise jede Stunde, alle sechs Stunden oder alle 24 Stunden. Basierend auf diesen SLAs koordiniert die Plattform mit dem Connector nur die geänderten Blöcke. Bevor die geänderten Bausteine gesichert werden, ruft der Connector Pre- und Post-Scripts auf, um die Datenbank einzufrieren und dann aufzutauen, so dass die geänderten Bausteine in einem datenbankbasierten Modus vorliegen.

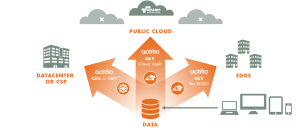

Nach jeder inkrementellen Sicherung erstellt die Plattform zur Virtualisierung von Datenkopien eine virtuelle Voll-Sicherung. Wenn der Benutzer eine Wiederherstellung zu einem bestimmten Zeitpunkt durchführen muss, erhält er immer ein vollständiges synthetisches Image. Sobald die Backups erstellt wurden, basierend auf SLAs, repliziert die virtuelle Appliance deduplizierte oder komprimierte Backup-Images zu einer entfernten virtuellen Appliance, die an einem Disaster-Recovery-Standort oder in einer Public-Cloud wie Microsoft-Azure, AWS oder Oracle-Cloud läuft. Sowohl am primären Standort als auch am entfernten Standort kann die virtuelle Appliance eine sofortige Wiederherstellung durch die Bereitstellung von Backup-Images auf dem Wiederherstellungsserver mit wenigen Klicks durchführen.

Im Idealfall kann die cloudbasierte Lösung Daten für den gewünschten Aufbewahrungszeitraum gemäß den vom Administrator spezifizierten SLAs vorhalten. Die virtuelle Appliance kann Daten für Tage, Wochen oder Monate in seinem Deduplizierungs-Pool speichern. Für eine Aufbewahrung über mehrere Jahre und Jahrzehnte werden Daten auf Objektspeicherplattformen verteilt – in der Cloud (z.B. Amazon S3, Azure-Blob, Softlayer oder Google-Cloud-Nearline) oder vor Ort (z.B. IBM Cleversafe / Cloud Object Storage). Eine cloudbasierte Lösung bietet sofortigen Zugriff auf Daten, die im Objektspeicher gespeichert sind, und zwar einfach durch das „Mounten“ eines Images, so dass Unternehmen die Daten für On-Demand-Cloud-Analyse oder Data-Warehousing-Anforderungen nutzen können.

Testdatenmanagement für Test-Dev- und DevOps-Teams

Die meisten großen Unternehmen beschäftigen eigene Teams für das Testen und Entwickeln von Anwendungen oder für DevOps. Diese Teams benötigen Kopien von Produktionsanwendungsdaten in ihren Testumgebungen. Actifio-Sky ermöglicht es den Teams und Datenbankadministratoren, virtuelle Kopien von Backup-Images auf einfache Weise in mehrere Linux-Testumgebungen nach dem Self-Service-Prinzip bereitzustellen. Beispielsweise können mehrere virtuelle Kopien einer 10-TByte-Datenbank sofort in verschiedenen Testumgebungen vom Dev- oder QA-Team selbst abgerufen werden, ohne die Datenbank beim Administrator langwierig erst anfordern zu müssen.

Dies ermöglicht es den Test-Dev- und DevOps-Teams, ihren Code immer gegen virtuelle Kopien von Produktionsdaten auf virtuellen Maschinen oder physischen Servern ab dem Tag Eins ihrer Sprint-Zyklen zu testen. Dies hilft ihnen, kritische Fehler frühzeitig in den Entwicklungs- und Qualitätsmanagementzyklen zu erfassen. Dadurch wird die Produktqualität verbessern und gleichzeitig können die Release-Zyklen beschleunigt werden. Da die virtuellen Kopien keinen zusätzlichen Speicherplatz verbrauchen, reduziert dies auch die Infrastrukturanforderungen für IT-Teams erheblich. Eine solche On-Demand-Bereitstellung von virtuellen Daten ist auch gut geeignet für DevOps-Teams, die On-Demand-Computing in der Cloud für Test-Dev-Zwecke nutzen wollen.

„Eine einheitliche Plattform für Datenmanagement, die für unternehmenskritische Linux-basierte Anwendungen vielfältige Funktionen wie Backup, Datenarchivierung, Disaster-Recovery und Testdatenmanagement für DevOps ermöglicht, nimmt den Administratoren der Linux-Umgebung viel Arbeit ab“, fasst Thorsten Eckert abschließend zusammen. „Backup ist ohnehin in den meisten Unternehmen eine ungeliebte Pflichtaufgabe. Warum also dann nicht den komfortablen Weg gehen?“.