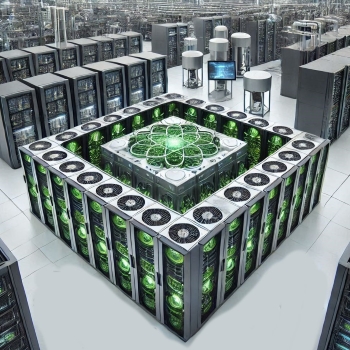

Um RZ-Betreiber bei der Integration von KI zu unterstützen, haben Schneider Electric und Nvidia gemeinsame Referenzdesigns für KI-Rechenzentren entwickelt. Die Hersteller-validierten Infrastruktur-Designs zeigen, wie sich hochdichte KI-Cluster mit bis zu 70 kW pro Rack sicher und effizient in neue oder bestehende Rechenzentren integrieren lassen.

Um RZ-Betreiber bei der Integration von KI zu unterstützen, haben Schneider Electric und Nvidia gemeinsame Referenzdesigns für KI-Rechenzentren entwickelt. Die Hersteller-validierten Infrastruktur-Designs zeigen, wie sich hochdichte KI-Cluster mit bis zu 70 kW pro Rack sicher und effizient in neue oder bestehende Rechenzentren integrieren lassen.

Künstliche Intelligenz (KI) entwickelt sich zu einer entscheidenden Zukunftstechnologie für die deutsche Wirtschaft. Laut einer gemeinsamen Studie von IDC und Statista planen deutsche Unternehmen bis 2026 Investitionen von über 8 Milliarden Euro in KI- und Analyse-Anwendungen. Dabei entfallen die größten Budgets auf die Bereiche Machine-Learning (30 %), Computer-Vision (25 %) und Natural-Language-Processing (19 %).

Die Integration von KI-Anwendungen hat weitreichende Auswirkungen auf die Unternehmens-IT und die RZ-Infrastruktur. Denn KI-Workloads stellen andere Anforderungen an grundlegende Parameter wie Rechenleistung, Speicherkapazität und Netzwerkbandbreite als klassische IT-Umgebungen. Statt herkömmlicher CPU-basierter Server kommen im KI-Umfeld GPU- und FPGA-Beschleuniger zum Einsatz, häufig in Form von High-Density-Clustern. Analysten erwarten, dass der KI-Boom zu einer deutlichen Erhöhung der Rack-Dichte in Serverräumen und Rechenzentren führen wird. Während heute noch Leistungen von 5-10 kWh pro Rack üblich sind, könnten in Zukunft 20, 30 oder gar 50 kWh zum Standard werden. Diese Entwicklung stellt Rechenzentrumsbetreiber vor enorme Herausforderungen, sowohl bei der Stromversorgung als auch bei der IT-Kühlung. Gleichzeitig wächst zudem der Druck, trotz steigender Leistungsdichte energieeffizient und nachhaltig zu planen, um Betriebskosten und CO2-Emissionen niedrig zu halten.

Während die Entwicklung großer GenAI-Modelle in erster Linie den führenden KI-Anbietern und Hyperscalern vorbehalten bleibt, gibt es für den lokalen Betrieb einer KI-Infrastruktur im unternehmenseigenen Rechenzentrum durchaus praktikable Anwendungsszenarien. Insbesondere bei der Evaluierung von spezialisierten ML-Anwendungen oder der Entwicklung von generativen Mikromodellen ergeben sich inzwischen sinnvolle Einsatzmöglichkeiten. Beispiele finden sich etwa in der industriellen Bildverarbeitung und Qualitätskontrolle, wo lokal trainierte KI-Modelle Produktionslinien überwachen, Fehler erkennen und die Qualitätssicherung automatisieren können. Auch im Bereich Predictive-Maintenance lassen sich mit lokal trainierten KI-Systemen Maschinenzustände überwachen oder Wartungsaufgaben optimieren. Weitere potenzielle Anwendungsfelder sind die Betriebsdatenanalyse zur Prozessoptimierung, personalisierte Empfehlungssysteme im Einzelhandel oder die automatisierte Verarbeitung von Dokumenten. Generelle Vorteile des lokalen KI-Betriebs sind eine erhöhte Datensicherheit bei der lokalen Verarbeitung von Unternehmensdaten, die Vermeidung von Latenzzeiten und eine höhere Unabhängigkeit gegenüber IT-Drittanbietern.

Mit Edge-AI ist derzeit eine weitere wichtige Entwicklung im Gange, die den Betrieb lokaler KI-Systeme zusätzlich beflügeln könnte. Edge-AI basiert dabei auf der Idee des Edge-Computings, bei dem Daten möglichst direkt vor Ort verarbeitet und analysiert werden. Ziel ist es, den Einsatz komplexer Recheninfrastrukturen und aufwändiger Datenkommunikation insgesamt zu reduzieren und in kleinere, dezentrale Infrastrukturen auszulagern. Edge AI verbindet diesen Ansatz zusätzlich mit dem Einsatz von Künstlicher Intelligenz. Dabei sollen unter anderem das Training von Modellen und die Bereitstellung von KI-Anwendungen direkt in der Edge stattfinden.

Herausforderungen hoher Leistungsdichte

Die Integration von KI-Workloads in bestehende Rechenzentren ist allerdings alles andere als trivial, denn die hohen Leistungsdichten moderner KI-Cluster stellen konventionelle Kühl- und Stromversorgungskonzepte vor immense Herausforderungen. Während herkömmliche, luftgekühlte IT-Racks typischerweise mit einer Leistungsaufnahme von unter 6 kW pro Rack auskommen, benötigen KI-Racks aufgrund ihrer leistungsfähigen GPUs oft mehr als 10 kW, in Spitzenszenarien sogar bis zu 70 kW pro Rack. Dies zeigt auch ein aktuelles Beispiel aus der Praxis: Das „NVIDIA DGX H100 System“ etwa integriert bis zu acht „NVIDIA H100 Tensor Core GPUs“ und erreicht damit eine Leistungsaufnahme von bis zu 700 W pro GPU bzw. 5,6 kW für das komplette 8-GPU-System. In einem Rack können jedoch bis zu 10 solcher DGX H100 Systeme untergebracht werden, was dann zu einer maximalen Gesamtleistungsaufnahme von ca. 56 kW pro Rack führt. Leistungsdichten wie diese erfordern nicht nur eine zuverlässige Stromversorgung mit entsprechend dimensionierten Strompfaden, sondern stellen auch höchste Anforderungen an die Kühlung.

Um die enormen Abwärmemengen effizient abzuführen, werden zunehmend Flüssigkeitskühltechnologien wie Direct-to-Chip-Systeme, Rear-Door-Wärmetauscher oder Immersionskühlung eingesetzt. Gleichzeitig müssen Rechenzentrumsbetreiber auch bei der Bereitstellung von KI-Lösungen die Energieeffizienz im Auge behalten und Kosten sowie CO2-Emissionen begrenzen. Denn KI-Workloads haben nicht nur einen höheren Leistungsbedarf, sondern oft auch ein völlig anderes Lastprofil als klassische IT-Anwendungen. Während bei Inferenz-Workloads Latenz und Verfügbarkeit oberste Priorität haben, spielen bei Trainings-Workloads vor allem Kosteneffizienz und Ausfallsicherheit eine Rolle, da die Systeme beim Training von KI-Modellen oft wochenlang unter Volllast laufen.

Validierte Referenzdesigns als Lösungsansatz

Um RZ-Betreiber bei der Integration von KI zu unterstützen, haben führende Anbieter wie Schneider Electric und Nvidia gemeinsame Referenzdesigns für KI-Rechenzentren entwickelt. Die Hersteller-validierten Infrastruktur-Designs zeigen, wie sich hochdichte KI-Cluster mit bis zu 70 kW pro Rack sicher und effizient in neue oder bestehende Rechenzentren integrieren lassen. Die Referenzdesigns von Schneider Electric beleuchten dabei verschiedene Szenarien für Retrofit-Lösungen und zeigen einen Designansatz für einen kompletten Neubau eines KI-Datacenters. Sie kombinieren innovative Technologien wie Hochtemperatur-Chiller für maximale Freikühlung, effiziente Lüfterwände und direkte Flüssigkeitskühlung zu einem ganzheitlichen, validierten Konzept. Trotz der extremen Leistungsdichten erreichen die Designs von Schneider Electric wettbewerbsfähige PUE-Werte von 1,15 bis 1,27 bei Volllast. Einer der größten Vorteile solcher Referenzdesigns liegt aber in der grundsätzlich vereinfachten Planung. RZ-Betreiber und Planer können dabei auf ein in der Praxis erprobtes und gut dokumentiertes Konzept zurückgreifen. Das spart nicht nur wertvolle Zeit, sondern reduziert auch Planungsrisiken, da alle Komponenten bereits aufeinander abgestimmt sind. Gleichzeitig bleiben die Designs flexibel genug, um sie an individuelle Anforderungen anzupassen.

Fazit

Die Integration von KI-Workloads kann Rechenzentrumsbetreiber vor enorme Herausforderungen stellen. Hohe Leistungsdichten, komplexe Kühlaufgaben und steigende Anforderungen an Verfügbarkeit und Effizienz müssen praxisgerecht unter einen Hut gebracht werden. Indem sie moderne IT-Technologien zu einem ganzheitlichen und validierten Infrastrukturkonzept kombinieren, bieten die gemeinsam von Schneider Electric und Nvidia entwickelten Referenzdesigns Betreibern bei der KI-Integration eine fundierte Orientierungshilfe. Für Unternehmen, die sich jetzt für das KI-Zeitalter rüsten wollen, sind die verschiedenen Referenzdesigns aus dem Designguide Nr. 99 daher eine attraktive Option. Denn sie ermöglichen es, von den Erfahrungen führender Experten zu profitieren und gleichzeitig eigene Anforderungen einfließen zu lassen. So kann die Integration von KI-Workloads sicher, effizient und zukunftsorientiert umgesetzt werden. Denn eines ist klar: Die KI-Revolution im Rechenzentrum hat gerade erst begonnen. Wer jetzt die richtigen Weichen stellt, wird langfristig profitieren.

Von Rainer Weigle, Schneider Electric

#SchneiderElectric