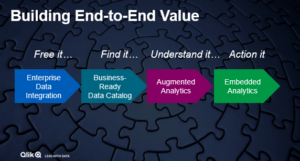

Wie wirkt sich ein Lockdown auf die Lieferkette aus? Wo entstehen Liquiditätsengpässe? Wie kann gegengesteuert werden? Die Pandemie hat den Unternehmen vor Augen geführt, wie wichtig es ist, schnell und datenbasiert auf Entwicklungen jeglicher Art reagieren zu können. Das Problem: Veraltete BI-Lösungen und Self-Service-Tools, mangelnde Datenintegration, fehlende Datenkompetenz. Datenbasiertes Entscheiden geht anders! Was man dafür benötigt? End-to-End-Lösungen, die von den Rohdaten über die Analyse bis hin zu Alerts und Handlungsempfehlungen die gesamte Daten- und Analyse-Chain umfassen. Die besonderen Herausforderungen liegen aktuell am Beginn und am Ende der Chain, das heisst bei der Datenintegration sowie am Übergang von der Analyse hin zur Business-Entscheidung.

Wie wirkt sich ein Lockdown auf die Lieferkette aus? Wo entstehen Liquiditätsengpässe? Wie kann gegengesteuert werden? Die Pandemie hat den Unternehmen vor Augen geführt, wie wichtig es ist, schnell und datenbasiert auf Entwicklungen jeglicher Art reagieren zu können. Das Problem: Veraltete BI-Lösungen und Self-Service-Tools, mangelnde Datenintegration, fehlende Datenkompetenz. Datenbasiertes Entscheiden geht anders! Was man dafür benötigt? End-to-End-Lösungen, die von den Rohdaten über die Analyse bis hin zu Alerts und Handlungsempfehlungen die gesamte Daten- und Analyse-Chain umfassen. Die besonderen Herausforderungen liegen aktuell am Beginn und am Ende der Chain, das heisst bei der Datenintegration sowie am Übergang von der Analyse hin zur Business-Entscheidung.

Datenintegration – keine Daten auf der Strecke lassen

Noch immer bleibt in Unternehmen der größte Teil der Daten ungenutzt. Der Grund: Sie liegen – strukturiert wie unstrukturiert – verteilt in fragmentierten, weitverzweigten Datensilos. Traditionelle Datenintegrationswerkzeuge wie historische Transaktionsberichte, statische Batch-Datenanalysen oder manuell codierte Befehle haben ausgedient, da sie viel zu schwerfällig und langwierig sind. „Wir benötigen automatisierte Prozesse, die sämtliche Daten in eine Daten-Pipeline zusammenführen,“ erklärt Wolfgang Kobek, SVP EMEA von Qlik. „Mit der Übernahme von Attunity können wir genau dies umsetzen: Daten automatisiert und echtzeitfähig integrieren – über alle wichtigen Data-Lakes, Streaming-Systeme, Datenbanken, Data-Warehouses, Mainframe-Systeme oder Cloud-Quellen hinweg.“ Basis hierfür sind unter anderem Technologien wie Echtzeit-Datenintegration, Realtime-Streaming, Data-Lake-Creation, Data-Warehouse Automation oder auch Change-Data-Capture (CDC). Letztere gilt als einer der Gamechanger für BI, denn sie macht es möglich, sämtliche Änderungen an Datensätze in Echtzeit und in vollem Umfang zu erfassen und zu integrieren. Völlig unabhängig davon, wo sie sich befinden, ob in Data-Warehouses oder im Data-Lakes.

Daten analysebereit katalogisieren

Im nächsten Schritt geht es darum, die Daten so aufzubereiten, dass diese für die Anwender und deren Fragestellungen analysefertig und zugänglich sind. Diese Datenmanagement-Aufgabe übernimmt Qlik-Data-Catalog auf der Basis von automatisierten Prozessen und Metadatentools. Er transformiert und reinigt regelwidrige Daten, klärt deren Herkunft und erschließt sie für die Analyse. „Über Data-Catalog erhalten die Mitarbeiter Zugriff auf die Daten aus allen Datenquellen des Unternehmens und können diese wie auf einem zentralen Daten-Marktplatz ‚shoppen‘, in ihren ‚Einkaufskorb‘ legen und für die Self-Service-Analyse ‚ausliefern‘,“ so Kobek weiter. Allerdings arbeiten aktuell noch viele Unternehmen mit Self-Service-Werkzeugen in Form von desktopbasierten BI-Systemen. Das Problem: Die Anwender können sich zwar über Excel-Tabellen großzügig an Daten aus Datenbanken bedienen, doch Themen wie Datensicherheit oder Single Point of Truth bleiben auf der Strecke. Mit Qlik-Catalog und entsprechenden Plattformansätzen lassen sich Governance-Richtlinien wie DSGVO-Vorgaben oder Rollenverteilungen umsetzen. Außerdem kann im Sinne einer Data-Lineage nachgewiesen werden, welche User, welche Daten genutzt haben. Innerhalb einer agilen und automatisierten Data-Pipeline können Anwender mit den „eingekauften“ Daten ihre eigenen Analyse-Dashboards aufbauen. Der Datenkatalog fungiert somit als Brücke zwischen Datenintegration und Datenanalyse bzw. zwischen IT und Business.

Daten in unterschiedlichste Richtungen auswerten

Vielen Unternehmen ist es wichtig, dass Entscheidungen nicht nur von KI bzw. Computern getroffen werden. Der Business-Anwender soll bei Maßnahmen oder auch bei Genehmigungen ins Boot geholt oder auf dem Laufenden gehalten werden. Deshalb wird aktuell der Ruf nach Systemen laut, die nicht nur auf reiner Artificial-Intelligence basieren, sondern KI und maschinelles Lernen mit menschlicher Datenkompetenz (Data-Literacy) zu Augmented-Intelligence verbinden, um den Anwendern bisher unbekannte Einblicke in unterschiedlichste BI-Anwendungsfälle zu ermöglichen. Voraussetzungen hierfür sind, dass erstens Daten nicht nur in linearen vordefinierten Pfaden abgefragt und analysiert werden, sondern uneingeschränkt in beliebige Richtung ausgewertet werden können. Zweitens ist es für die Anwender wichtig, in natürlicher Sprache mit dem System zu interagieren und sprachgesteuerte Analysen anstoßen zu können. Im besten Fall erhalten sie vom System Antworten in Freitext, Auswertungsvorschläge, Empfehlungen zur Kombination von Datenquellen oder auch relevante Grafiken und Einblicke inklusive relevanter KPIs, Vergleiche oder Prognosen.

Analytics und intelligentes Alerting in den Workflow integrieren

„Allerdings wäre es kompliziert und zeitaufwändig,“ ergänzt Kobek, „wenn die Anwender für Analysen und datenbasierte Entscheidungen immer in separate Anwendungen wechseln müssten. Sie benötigen die entsprechenden Informationen und Tools direkt und ohne Verzögerungen in ihrem persönlichen Workflow.“ Kommt eine Plattform mit Embedded-Analytics-Möglichkeiten zum Einsatz, können die Analysefunktionen und Inhalte direkt z.B. in ERP-, CRM- oder auch HR-Anwendungen und -Prozesse integriert werden. Durch intelligentes Alerting werden Parameter oder Merkmale bzw. die dahinterliegenden Daten und Änderungen automatisiert in Echtzeit überwacht und Warnmeldungen an den Anwender oder beispielsweise auch in das ERP-System ausgespielt, so dass Entscheidungen schnell getroffen oder Prozesse unmittelbar angestoßen werden. Der Vorteil: Unternehmen können ihre Geschäftsdaten proaktiv überwachen, Insights generieren und rechtzeitig Maßnahmen ergreifen.

Active-Intelligence – wenn Daten zu messbaren Ergebnissen führen

Laut IDC liegen 90 Prozent aller Rohdaten in den Unternehmen brach. Deshalb gehört intelligenten End-to-End-Plattformen, die in durchgängigen Daten-Pipelines Datenintegration und Datenanalyse zusammenführen, die Zukunft. „All diese Möglichkeiten entfalten allerdings nur dann ihre volle Wirkung, wenn wir es mit datenkompetenten Anwendern zu tun haben, die Daten lesen, bearbeiten, analysieren und mit diesen zu argumentieren verstehen,“ resümiert Kobek. „Wenn Technologie und Kompetenz zusammenspielen und ihre volle Wirkung entfalten, entsteht Active Intelligence. Die Unternehmen generieren datenbasierte Erkenntnisse in Echtzeit und können Maßnahme ergreifen, die sich direkt auf die Unternehmensergebnisse auswirken.“

#Qlik